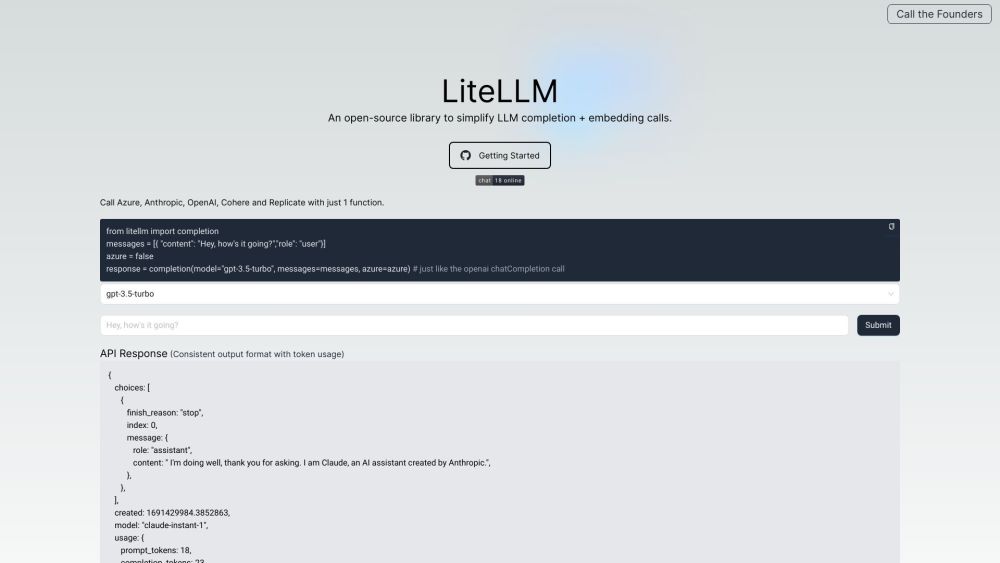

LiteLLM 是什么?

LiteLLM是一个开源库,致力于为开发者提供简化大语言模型(LLM)完成和嵌入调用的便捷接口。它不仅支持多种流行的LLM模型,比如GPT-3.5-turbo和Cohere的command-nightly,还设有一个内置的演示平台,帮助用户轻松比较各个模型在不同任务上的表现。这种设计旨在降低技术门槛,让更多开发者能够快速上手,充分挖掘AI技术的潜力。

LiteLLM 有哪些功能?

LiteLLM的核心功能包括高效简化LLM完成和嵌入调用的流程,兼容多个主流LLM模型。此外,演示平台让用户能够在实际应用中测试和比较不同模型的效果,从而选择最适合其需求的解决方案。这种多样化的功能使得LiteLLM成为开发者进行自然语言处理的强大工具。

如何使用 LiteLLM?

使用LiteLLM非常简单。首先,需要导入'litellm'库并配置必要的环境变量,例如OPENAI_API_KEY和COHERE_API_KEY。接下来用户可以创建Python函数,通过调用LiteLLM完成各种自然语言处理的任务。此外,内置的演示现场不仅支持代码编写,还会即时显示结果,让用户可以快速验证和优化自己的代码。

LiteLLM 的使用案例

LiteLLM为文本生成、语言理解及聊天机器人开发等自然语言处理应用提供了广泛的可能性。无论是学术研究还是商业项目,LiteLLM都能作为一个灵活的支持工具,帮助开发者构建高效的应用程序。通过结合多个模型,开发者可以更好地满足用户的特定需求,提升产品的价值和用户体验。

适用人群

LiteLLM适合各种群体,包括数据科学家、AI技术研究者及软件开发者。无论您是进行学术研究还是商业应用开发,通过LiteLLM都能快速有效地利用大语言模型的强大功能。其简单的接口和丰富的功能,使每一位用户都可以轻松掌握,提升工作效率。

LiteLLM 的常见问题

LiteLLM支持哪些LLM模型?

LiteLLM支持多种流行的LLM模型,包括GPT-3.5-turbo和Cohere的command-nightly。用户可以根据自身需求灵活选择使用特定模型,以实现最佳效果。

LiteLLM可以用于研究目的吗?

可以的,LiteLLM非常适合研究使用。内置的演示场地允许用户比较不同LLM模型的表现,这对于研究人员探索模型特性和性能非常有帮助。

LiteLLM有自己的定价吗?

LiteLLM作为一个开源库,并不设有独立的定价机制。但请注意,所使用的底层LLM模型可能会有不同的定价,请参考相应提供商的信息。

LiteLLM中的演示场地是什么?

演示场地是LiteLLM提供的一个内置功能,用户可以在这个界面上编写代码并查看即时结果。演示场地的设计旨在让用户方便地比较不同模型的表现,提升了使用体验,助力开发者更高效地完成各类任务。